Искусственный интеллект не стоит на месте, и одна из самых быстро развивающихся областей – это большие языковые модели (LLM). В этой статье мы рассмотрим ключевые тенденции и вызовы, с которыми сталкиваются LLM сегодня, а также поговорим о том, чего могут ожидать пользователи от последних разработок.

От генерации текста до современных гигантов:

Большие языковые модели – это массивные трансформеры, которые являются типом модели глубокого обучения или, проще говоря, специальными нейронными сетями. Как правило, LLM имеют от 8 миллиардов до 70 миллиардов параметров и обучаются на огромном количестве данных. Например, Crawl, один из самых больших наборов данных, содержит веб-страницы и информацию за последнее десятилетие, что составляет десятки петабайт данных.

LLM имеют длинную историю, они не появились внезапно. Например, отдел данных ELEKS использовал GPT-2 для генерации ответов в 2019 году, в то время как первая модель GPT (generative pre-trained transformer) была выпущена в 2018 году. Однако даже это не было первым появлением моделей генерации текста. До начала эры трансформеров в 2017 году такие задачи, как генерация текста, решались с помощью разных подходов, например:

- Генеративно-состязательные сети – подход, где генератор обучается на основе отзывов от другой сети или дискриминатора.

- Автокодировщики – известный и широко используемый подход, где модель пытается воспроизвести входные данные.

В 2013 году были предложены эффективные векторные вложения слов, такие как word2vec, а еще раньше, в прошлом веке, существовали примеры вероятностной и шаблонной генерации, например, чат-бот Eliza в 1964 году. Как мы видим, задачи и попытки в сфере генерации естественного языка (NLG) существуют уже много лет.

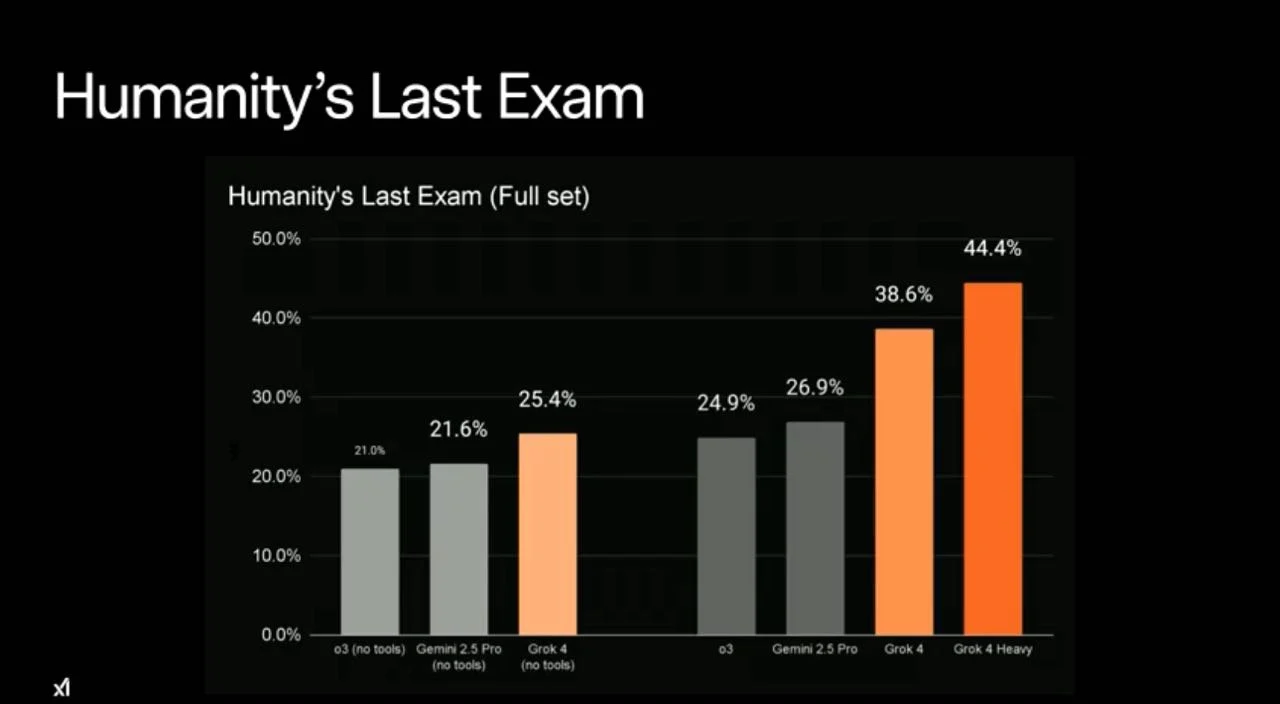

Большинство современных пользователей LLM, таких как ChatGPT, GPT, Gemini, Copilot, Claude и др., вероятно, не знают об этом, потому что результаты не были такими обещающими, как после первого релиза InstructGPT, где OpenAI предложила публичный доступ, продвигая его. За первым релизом ChatGPT в ноябре 2022 года, который получил миллионы упоминаний в социальных сетях, следует не один значительный прорыв.

Дебаты о регулировании ИИ: баланс между инновациями и безопасностью

В настоящее время сообщество ИИ разделено по вопросу о рисках ИИ и необходимости регулирования, причем некоторые призывают к регулированию ИИ и контролю безопасности, а другие против этого. В числе критиков – Ян Лекун, главный ученый Meta* (Facebook*) по ИИ, который заявил, что такие агенты ИИ имеют интеллект, даже не сравнимый с интеллектом собаки.

Группа Meta* AI (ранее Facebook* AI Research) – один из разработчиков бесплатных и общедоступных моделей ИИ, таких как Detectron, Llama, SegmentAnything и ELF, которые можно свободно скачать и использовать с некоторыми коммерческими ограничениями. Открытый доступ определенно был благоприятно воспринят мировым сообществом ИИ.

“Эти системы все еще очень ограничены; у них нет понимания основной реальности реального мира, потому что они обучены исключительно на тексте, огромном количестве текста.”

— Ян Лекун, главный ученый по ИИ в Meta*

За регулирование ИИ высказались также чиновники. Например, президент Франции Эммануэль Макрон предупредил, что законодательство ЕС, направленное на управление развитием искусственного интеллекта, рискует помешать европейским технологическим компаниям по сравнению с конкурентами в США, Великобритании и Китае.

С другой стороны, существуют сторонники регулирования ИИ. По мнению Илона Маска, генерального директора Tesla, ИИ – один из самых больших рисков для будущего цивилизации. Эта позиция совпадает с позицией непубличных/платных представителей ИИ, но здесь реальные движущие силы такой позиции могут быть конкуренцией на рынке – ограничение распространения конкурирующих моделей ИИ.

Обзор закона ЕС об искусственном интеллекте

В 2023 году Европейский парламент принял закон об ИИ, первый набор всеобъемлющих правил, регулирующих использование технологий ИИ в Европейском союзе. Этот законодательный акт устанавливает прецедент для ответственного и этичного развития и внедрения ИИ.

Ключевые вопросы, которые регулирует закон ЕС об ИИ:

- Ограничения на обработку персональных данных: в соответствии с разными стандартами, такими как GDPR (ЕС), APPI (Япония), HIPPA (США) и PIPEDA (Канада), которые регулируют обработку персональных данных, биометрическую идентификацию и т. д.

- Системы оценивания или любая форма категоризации людей: где предвзятость модели может иметь значительное влияние, что может привести к дискриминации.

- Манипулирование поведением: некоторые модели могут пытаться увеличить любые бизнес-показатели (коэффициенты конверсии, перепотребление).

Подготовка и использование модели ИИ: вызовы и проблемы

Существует много проблем и проблем, связанных с подготовкой модели, ее использованием и другими скрытыми действиями. Например, данные, используемые для обучения модели, состоят из персональных данных, которые не были разрешены для таких целей. Глобальные поставщики предлагают услуги, сосредоточенные на частной переписке (электронная почта) или других частных активах (фотографии, видео), которые могут использоваться для обучения модели в скрытом режиме без оповещения.

Недавно была задана вопрос техническому директору OpenAI относительно использования частных видео для обучения SORA, непубличной службы OpenAI по генерации видео на основе текстовых запросов, но она не смогла дать четкого ответа.

Еще одна проблема может быть связана с разметкой и фильтрацией данных – мы не знаем личных характеристик, навыков, стереотипов и знаний специалистов, задействованных в этом, и это может привести к нежелательным заявлениям/контенту в данных. Кроме того, возник этичный вопрос – была информация о том, что некоторые из глобальных поставщиков GenAI привлекали разметчиков из Кении и платили им слишком мало.

Предвзятость модели и так называемые галлюцинации модели, когда модели дают неправильные или частично неправильные ответы, которые кажутся идеальными, также являются проблемами. Недавно команда данных ELEKS работала над улучшением решения по генерации с учетом извлечения (RAG) наших клиентов, которое включает в себя показ некоторых данных модели, а модель резюмирует или дает ответы на основе этих данных.

В ходе работы наша команда поняла, что многие современные онлайн (более крупные, но платные) или офлайн (более мелкие и публичные) модели путают названия и номера предприятий.

У нас были данные, содержащие финансовую отчетность и аудиторскую информацию для нескольких компаний, и запрос состоял в том, чтобы показать выручку компании A. Однако выручка компании A не была прямо указана в данных и требовала расчета. Большинство моделей, включая лидеров в бенчмарке LLM Arena, ответили неверным уровнем выручки, который принадлежал компании B. Эта ошибка произошла из-за частично похожих комбинаций символов в названиях компаний, таких как “Ltd”, “Service” и т. д.

Здесь даже обучение промпта не помогло; добавление утверждения, такого как “если вы не уверены или отсутствует некоторая информация, пожалуйста, ответьте “не знаю””, не решило проблему.

Еще одна вещь – это числовое представление – LLM воспринимают числа как токены, или даже как множество токенов, например, 0.33333 может быть закодировано как ‘0.3’ и ‘3333’ в соответствии с подходом байт-парного кодирования, поэтому сложно справиться со сложными численными преобразованиями без дополнительных адаптеров.

Недавнее назначение отставного генерала армии США Пола М. Накасона в совет директоров OpenAI вызвало смешанные реакции. С одной стороны, обширный опыт Накасона в кибербезопасности и разведке рассматривается как значительный актив, который, вероятно, будет использован для реализации надежных стратегий защиты от кибератак, что имеет огромное значение для компании, занимающейся исследованиями и разработкой ИИ.

С другой стороны, существуют опасения по поводу возможных последствий назначения Накасона из-за его военного и разведывательного прошлого (бывший глава Агентства национальной безопасности (АНБ) и Киберкомандования США), что может привести к усилению государственного надзора и вмешательства.

Существуют опасения, что Накасон может обеспечить более широкий доступ государственных органов к данным и услугам OpenAI. Таким образом, некоторые боятся, что это назначение может повлиять как на использование сервиса, данных, запросов государственных органов, так и на ограничения самого сервиса.

Наконец, существуют и другие проблемы, например, уязвимость сгенерированного кода, противоречивые предложения, ненадлежащее использование (сдача экзаменов или получение инструкций о том, как создать бомбу) и многое другое.

Как улучшить использование LLM для более надежных результатов

Во-первых, необходимо определить, необходима ли LLM и должна ли она быть общей фундаментальной моделью. В некоторых случаях цель и разделенная задача не так сложны и могут быть решены более простыми офлайн моделями, такими как проверка орфографии, генерация на основе шаблонов и разбор/извлечение информации. Кроме того, общая модель может отвечать на вопросы, не связанные с предназначением интеграции LLM.

Существуют примеры, когда компания поощряла интеграцию онлайн LLM (например, GPT, Gemini) без каких-либо дополнительных адаптеров (предварительная и последующая обработка) и сталкивалась с неожиданным поведением. Например, пользователь попросил чат-бота автосалона написать скрипт на Python для решения уравнения Навье-Стокса для течения жидкости, и чат-бот сказал: “Конечно! Я это сделаю.”

Затем возникает вопрос о том, какую LLM использовать – публичную и офлайн или платную и офлайн. Решение зависит от сложности задачи и вычислительных возможностей. Онлайн и платные модели больше и имеют более высокую производительность, в то время как офлайн и публичные модели требуют значительных затрат на хостинг, часто необходима не менее 40 ГБ видеопамяти. При использовании онлайн моделей необходимо строго контролировать конфиденциальные данные, передаваемые поставщику.

Как правило, для этого мы строим модуль предварительной обработки, который может удалять личную или конфиденциальную информацию, например, финансовые данные или частные соглашения, не меняя при этом запрос существенно, чтобы сохранить контекст, оставляя информацию, такую как размер предприятия или приблизительное местоположение, если необходимо.

Первым шагом к снижению предвзятости модели и избеганию галлюцинаций является выбор правильных данных или контекста или ранжирование кандидатов (например, для RAG). Иногда векторное представление и метрики сходства, такие как косинусное сходство, могут быть неэффективны. Это происходит потому, что небольшие изменения, например, наличие слова “нет” или незначительные различия в названиях (например, Oracle против Orache), могут иметь значительное влияние.

Что касается последующей обработки, мы можем дать модели инструкцию отвечать “не знаю”, если уверенность низкая, и разработать адаптер проверки, который проверяет точность ответов модели.

Новые тенденции и будущее развитие в сфере LLM

В сфере LLM существует много направлений исследований, и каждую неделю появляются новые научные статьи. Эти статьи охватывают широкий круг тем, включая оптимизацию трансформеров/LLM, устойчивость, эффективность (например, как обобщить модели, не увеличивая существенно их размер или количество параметров), типичные методы оптимизации (например, дистилляция) и методы увеличения длины входных данных (контекста).

Среди различных направлений в последнее время выделяются Mixture-of-tokens, Mixture-of-experts, Mixture-of-depth, Skeleton-of-thoughts, RoPE и Chain-of-thoughts prompting. Давайте кратко опишем, что означает каждый из них.

Mixture-of-experts (MoEs) – это другая архитектура трансформера. Как правило, она имеет динамический слой, состоящий из нескольких (8 в Mixtral) или многих плотных/сглаженных слоев, представляющих разные знания. Эта архитектура включает в себя методы переключения или маршрутизации, например, функцию затвора, которая позволяет выбрать, какие токены должны обрабатываться какими экспертами, что приводит к сокращению количества слоев (“экспертов”) на токен или группу токенов до одного эксперта (слой переключения).

Это позволяет эффективно масштабировать модель и улучшает производительность за счет использования разных подмоделей (экспертов) для частей входа, что делает ее более эффективной, чем использование одного общего и даже более крупного слоя.

Mixture-of-tokens связан с упомянутым Mixture-of-experts, где мы группируем токены по их важности (активация softmax) для определенного эксперта.

Mixture-of-depth также связан с упомянутым MoEs, в частности, с точки зрения маршрутизации. Он нацелен на сокращение вычислительного графа (вычислительного бюджета), ограничивая его топ-токенами, которые будут использоваться в механизме внимания. Токены, считающиеся менее важными (например, знаки препинания) для определенной последовательности, пропускаются. Это приводит к динамическому участию токенов, но число токенов k (топ k токенов) статично, поэтому мы можем уменьшить размеры в соответствии с вычислительным бюджетом (или k, который мы выбрали).

Skeleton-of-thoughts эффективен для масштабирования LLM и позволяет генерировать части заполнения (ответа модели) параллельно на основе основного запроса “скелета”, который состоит из точек, которые можно параллелизовать.

Существуют и другие проблемы, например, размер входа. Пользователи часто хотят предоставить LLM большое количество информации, иногда даже целые книги, при этом сохраняя количество параметров без изменений. Вот два известных метода ALiBi (Attention Layer with Linear Biases) и RoPE (Rotary Position Embedding), которые могут экстраполировать или, возможно, интерполировать, встраивание входа с помощью динамического позиционного кодирования и коэффициента масштабирования, позволяя пользователям увеличить длину контекста по сравнению с тем, что использовалось для обучения.

Chain-of-thoughts prompting, который является примером few-shot prompting (пользователь предоставляет наблюдение для LLM в контексте), нацелен на разделение вопроса на несколько шагов. В основном, он применяется к задачам логического вывода, например, когда вы можете разделить логику на некий вычислительный план. Пример из исходной статьи: “У Роджера есть 5 теннисных мячей. Он покупает еще 2 банки теннисных мячей. В каждой банке 3 теннисных мяча. Сколько теннисных мячей у него теперь? План мышления: Роджер начал с 5 мячей. 2 банки по 3 теннисных мяча в каждой – это 6 теннисных мячей. 5 + 6 = 11. Ответ – 11.”

Помимо этого, существует много других направлений, и каждую неделю появляется несколько новых значимых статей о них. Иногда для специалистов по данным возникает дополнительная проблема, связанная с отслеживанием всех этих вызовов и достижений.

Что могут ожидать конечные пользователи от последних разработок ИИ?

Также существует много тенденций, подводя итог, можно сказать, что могут появиться более строгие правила регулирования ИИ, которые будут ограничивать различные решения и в конечном итоге приведут к обобщению доступных моделей или к расширению их области применения. Другие тенденции в основном связаны с улучшением существующих подходов, например, сокращением количества параметров и необходимой памяти (например, квантование или даже 1-битные LLM – где каждый параметр является троичным (может принимать значения -1, 0, 1)).

Таким образом, мы можем ожидать офлайн LLM или Diffusion Transformers (DiT – современные модели Diffusion и преемники визуальных трансформеров (в основном для задач генерации изображений)), работающие даже на наших телефонах (сейчас существует несколько примеров, например, модель Microsoft Phi-2, скорость генерации которой составляет около 3-10 токенов в секунду на современных устройствах Android на базе Snapdragon).

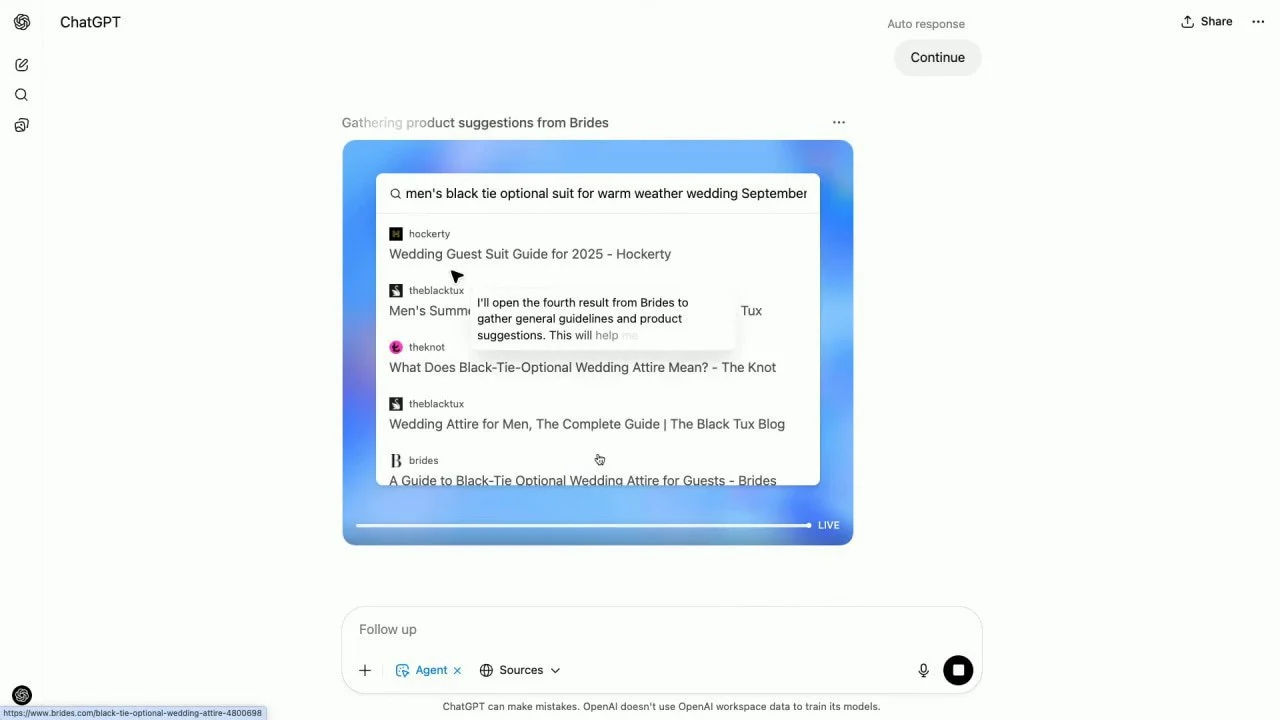

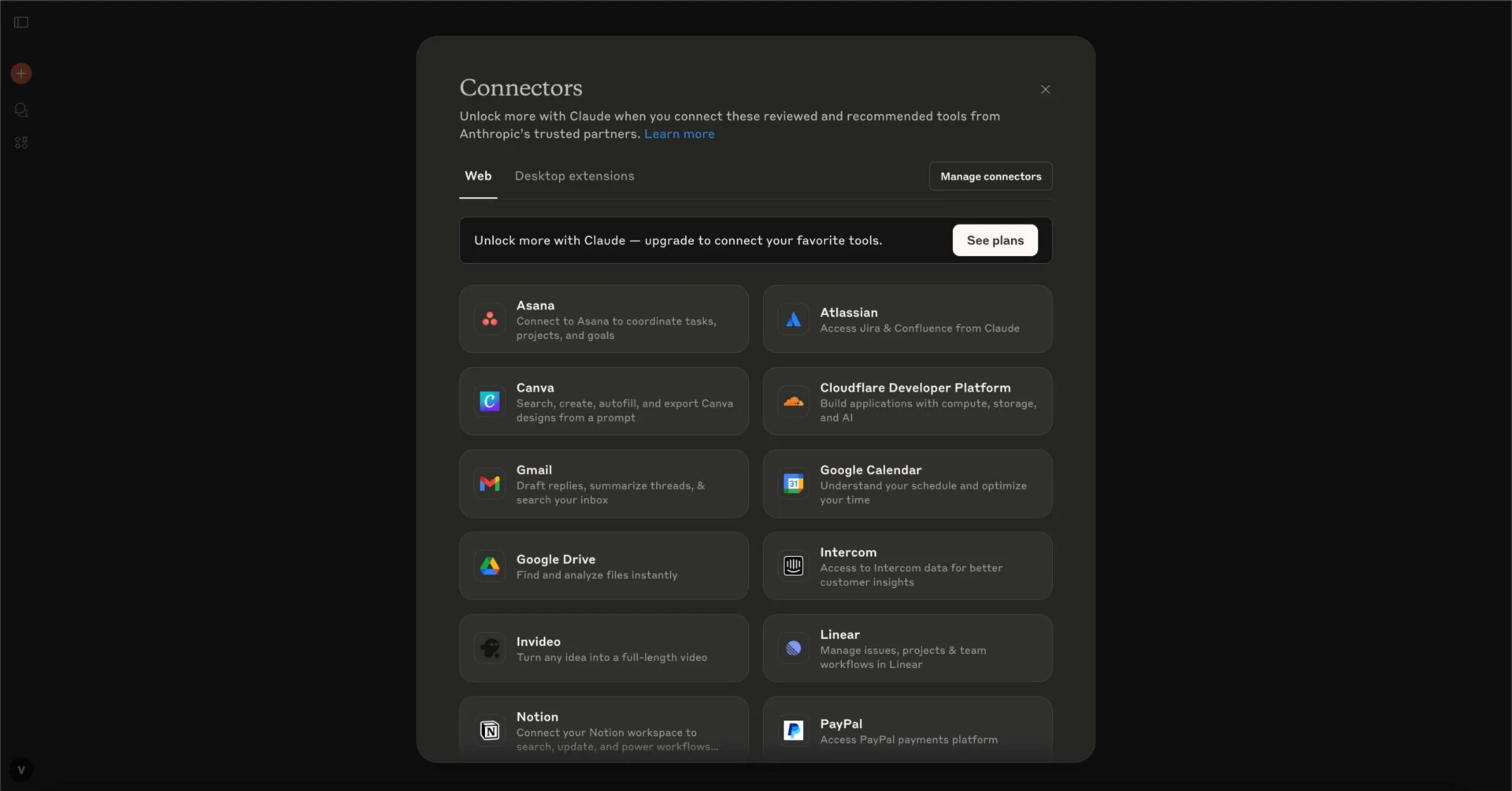

Кроме того, будет усовершенствована персонализация (использование всего предыдущего опыта и отзывов пользователей для предоставления более подходящих результатов), вплоть до цифровых близнецов. Также будут улучшены многие другие вещи, доступные прямо сейчас – помощники/настройка модели и рынки, одна модель для всего (мультимодальное направление), безопасность (более эффективный механизм работы с персональными данными, их кодирование и т. д.) и другие.

* Meta (Facebook) признана в РФ экстремистской и запрещёна на территории страны.

Источник: hackernoon