Перевод статьи на TechCrunch

Часто говорят, что большие языковые модели (LLM), такие как ChatGPT от OpenAI, – это черный ящик, и, конечно, в этом есть доля правды. Даже ученым, изучающим данные, трудно понять, почему модель всегда отвечает именно так, как она отвечает, – это все равно, что придумывать факты из ничего.

В попытке очистить LLM от поверхностных слоев OpenAI разрабатывает инструмент для автоматического определения того, какие части LLM отвечают за то или иное поведение. Инженеры, стоящие за этой разработкой, подчеркивают, что она находится на ранней стадии, но код для ее запуска доступен в открытом виде на GitHub по состоянию на сегодняшнее утро.

“Мы пытаемся [разработать способы] предвидеть, какие проблемы возникнут с системой ИИ”, – сказал в телефонном интервью TechCrunch Уильям Сондерс, руководитель группы интерпретируемости в OpenAI. “Мы хотим действительно иметь возможность знать, что мы можем доверять тому, что делает модель, и тому ответу, который она выдает”.

Для этого инструмент OpenAI использует языковую модель (по иронии судьбы) для выяснения функций компонентов других, архитектурно более простых LLM – в частности, собственной модели OpenAI GPT-2.

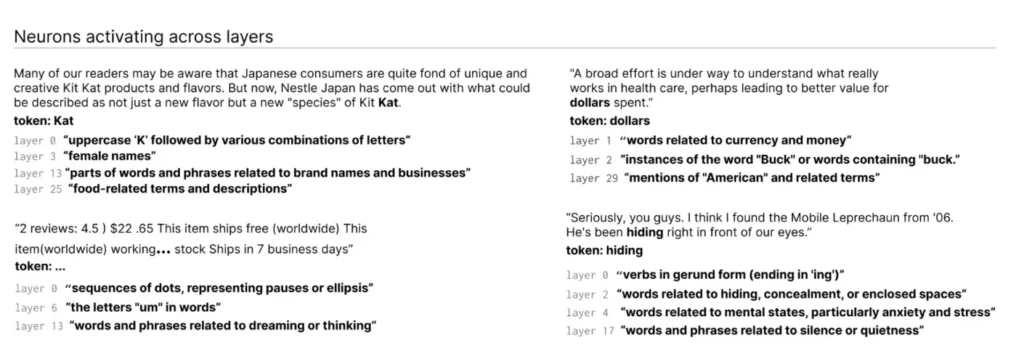

Каким образом? Для начала – краткое пояснение о LLM. Подобно мозгу, они состоят из “нейронов”, которые наблюдают за определенным шаблоном в тексте, чтобы повлиять на то, что общая модель “скажет” дальше. Например, если задать вопрос о супергероях (например, “Какие супергерои обладают самыми полезными суперспособностями?”), “нейрон супергероев Marvel” может увеличить вероятность того, что модель назовет конкретных супергероев из фильмов Marvel.

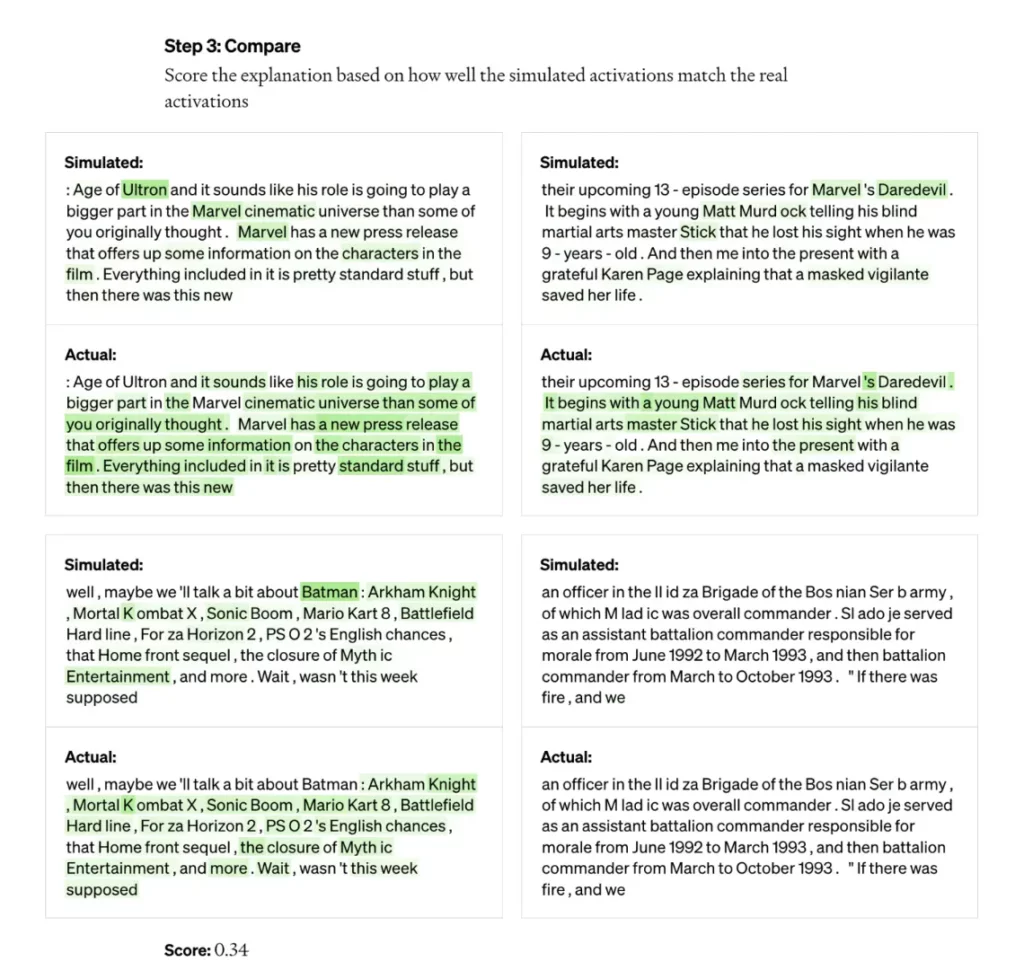

Инструмент OpenAI использует эту схему для разделения моделей на отдельные части. Сначала инструмент прогоняет текстовые последовательности через оцениваемую модель и ждет случаев, когда определенный нейрон “активируется” часто. Затем он “показывает” GPT-4, новейшей модели ИИ OpenAI, генерирующей текст, эти высокоактивные нейроны и заставляет GPT-4 генерировать объяснение. Чтобы определить, насколько точным является объяснение, инструмент предоставляет GPT-4 текстовые последовательности и заставляет его предсказать, или смоделировать, поведение нейрона. Затем инструмент сравнивает поведение смоделированного нейрона с поведением реального нейрона.

“Используя эту методологию, мы можем для каждого нейрона придумать предварительное объяснение на естественном языке того, что он делает, а также оценить, насколько хорошо это объяснение соответствует реальному поведению”, – говорит Джефф Ву, руководитель группы масштабируемого выравнивания в OpenAI. “Мы используем GPT-4 как часть процесса для создания объяснений того, что ищет нейрон, а затем оцениваем, насколько хорошо эти объяснения соответствуют реальному поведению”.

Исследователи смогли создать объяснения для всех 307 200 нейронов в GPT-2, которые они собрали в набор данных, выпущенный вместе с кодом инструмента.

По словам исследователей, подобные инструменты могут однажды быть использованы для улучшения работы LLM – например, для уменьшения предвзятости или токсичности. Однако они признают, что им предстоит пройти долгий путь, прежде чем они станут по-настоящему полезными. Инструмент был уверен в своих объяснениях примерно для 1 000 нейронов, что составляет небольшую часть от общего числа.

Циничный человек может также утверждать, что инструмент является, по сути, рекламой GPT-4, учитывая, что для его работы требуется GPT-4. Другие инструменты интерпретируемости LLM менее зависимы от коммерческих API, например, Tracr от DeepMind, компилятор, который переводит программы в модели нейронных сетей.

Ву сказал, что это не так – тот факт, что инструмент использует GPT-4, является лишь “случайным” – и, напротив, показывает слабость GPT-4 в этой области. Он также сказал, что инструмент не был создан с целью коммерческого применения и теоретически может быть адаптирован для использования LLM, помимо GPT-4.

“Большинство объяснений довольно плохо или вообще не объясняют поведение реального нейрона”, – сказал Ву. “Многие нейроны, например, активны так, что очень трудно определить, что происходит – например, они активируются на пять или шесть разных вещей, но нет никакой заметной закономерности. Иногда различимый паттерн есть, но GPT-4 не может его обнаружить”.

И это не говоря уже о более сложных, новых и больших моделях, или моделях, которые могут просматривать информацию в Интернете. Но что касается второго пункта, Ву считает, что просмотр веб-страниц не сильно изменит базовые механизмы инструмента. По его словам, его можно просто подстроить, чтобы выяснить, почему нейроны решают делать определенные запросы в поисковых системах или посещать определенные веб-сайты.

“Мы надеемся, что это откроет перспективный путь к решению проблемы интерпретируемости автоматизированным способом, который другие смогут развивать и вносить свой вклад”, – сказал Ву. “Мы надеемся, что у нас действительно будут хорошие объяснения не только того, на что реагируют нейроны, но и общего поведения этих моделей – какие схемы они вычисляют и как определенные нейроны влияют на другие нейроны”.