GPT-4 представляет собой значительный прорыв в развитии возможностей больших языковых моделей. Разработанная компанией OpenAI, она опирается на архитектуру и сильные стороны GPT-3, достигая при этом новых уровней масштабирования и производительности.

В данной статье приведены основные сведения о GPT-4, основанные на доступной в настоящее время публичной информации.

Основные характеристики GPT-4:

- Масштаб: С около 1,8 триллиона параметров GPT-4 в 10 раз превосходит GPT-3 по размеру. Это позволяет модели обрабатывать информацию с невероятной детализацией.

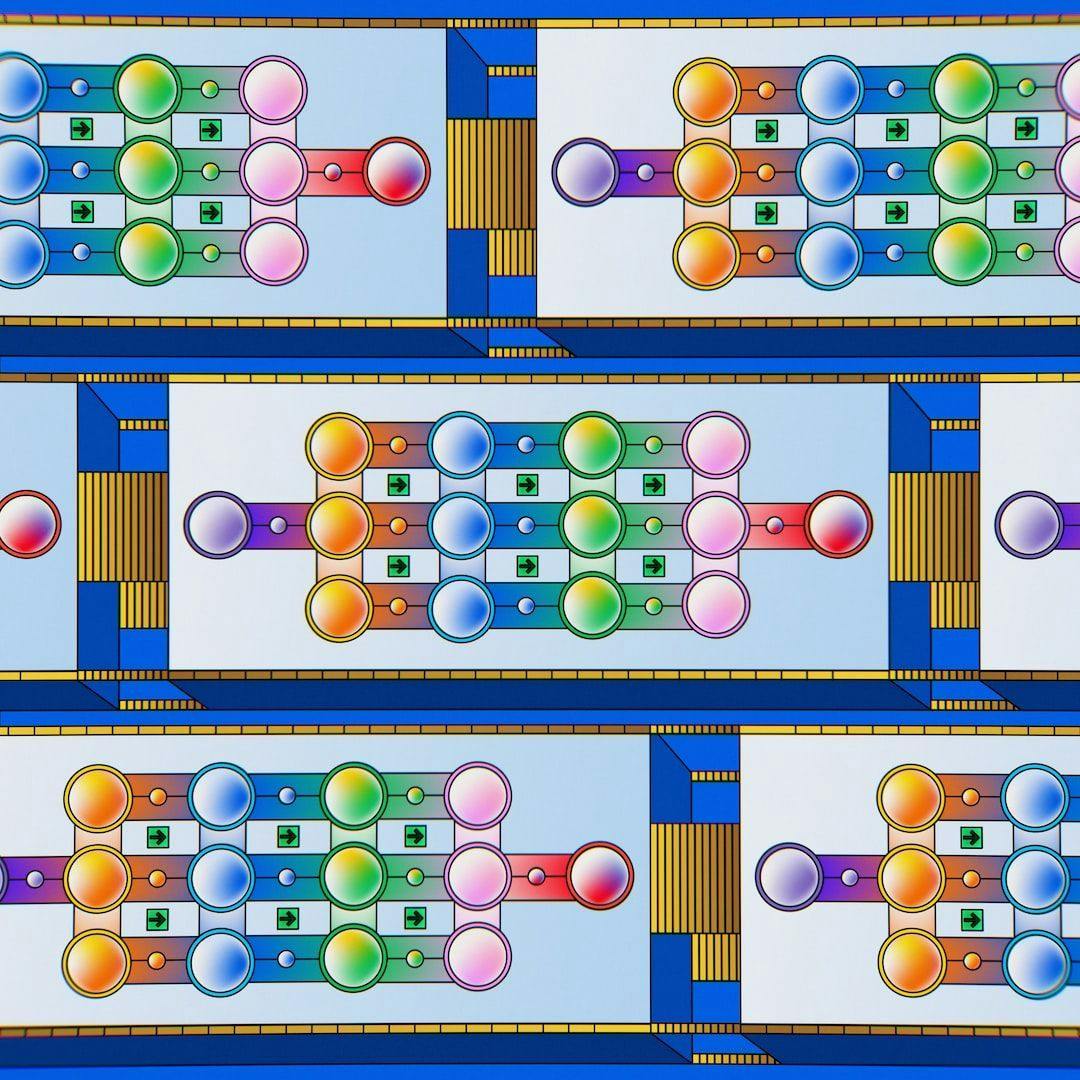

- Архитектура: Основываясь на концепции “смеси экспертов”, GPT-4 использует отдельные нейронные сети для различных задач или типов данных. Это позволяет модели быть более гибкой и адаптивной.

- Обучение: Процесс обучения был настолько интенсивным, что потребовалось около 25 000 графических процессоров Nvidia A100 и 90-100 дней непрерывной работы.

- Длина контекста: Поддерживается до 32 000 токенов текста

Параметры модели:

Тип модели: Преобразователь со смесью экспертов

Обучающие данные: Веб-тексты, книги, Википедия, Reddit, обзоры Amazon.

Предполагаемые области применения: Генерация текстов, QA, классификация, разговорные агенты

Возможности: Генерация текста, контроль качества, классификация

Модальности: Текст

Этические соображения: Возможность предвзятости, вредных результатов, неправильного использования

Ограничения: Отсутствие обоснованной аргументации, фактологически неверные результаты

Детальный разбор архитектуры:

GPT-4 использует архитектуру “смесь экспертов”, которая включает в себя отдельные нейронные сети-эксперты. Эти “эксперты” специализируются на определенных задачах или типах данных, что позволяет модели быть более точной и эффективной. Каждый из 16 экспертных моделей имеет около 111 миллиардов параметров, что делает их чрезвычайно мощными.

Процесс обучения

Обучение модели с 1,8 трлн параметров потребовало значительных вычислительных ресурсов:

- Обучение проводилось на ~25 000 графических процессорах Nvidia A100 одновременно

- 90-100 дней непрерывного обучения

- 13 триллионов обучающих токенов

- 2,15e25 операций с плавающей запятой (FLOPs) всего

Различные технологии синхронизации позволили достичь такого масштаба:

- 8-поточный тензорный параллелизм

- 15-поточный конвейерный параллелизм

- Топологии кластеризации для максимизации пропускной способности между процессорами

Обработка результатов

Для развертывания GPT-4 также требуется специализированная инфраструктура:

- Работает на кластерах из 128 графических процессоров A100

- Используется 8-поточный тензорный и 16-поточный конвейерный параллелизм

- Тщательный баланс между задержкой, пропускной способностью и утилизацией

- Для повышения пропускной способности используется спекулятивное декодирование

Плотные кластеры выводов обеспечивают доступную стоимость запросов в масштабе.

Сбрасывание токенов

Механизм маршрутизации MoE может приводить к отбрасыванию маркеров, когда некоторые маркеры остаются необработанными из-за ограничений пропускной способности экспертов.

- Отбрасывание не является детерминированным и основано на пакетной маршрутизации токенов.

- Некоторый уровень отсева полезен для эффективности

- Варьирование отбрасывания приводит к наблюдаемой случайности, но логика модели остается последовательной

Будущие направления

Несмотря на впечатляющие результаты, GPT-4 по-прежнему ориентирован на работу с текстом. Будущие области исследований включают:

- Архитектуры, поддерживающие зрение, аудио, речь

- Обучение на разных модальностях

- Альтернативы MoE для масштабируемости

- Расширение разнообразия и увеличение объема обучающих данных

- Продвижение мультимодальных рассуждений

- Оптимизация под реальную производительность

GPT-4 демонстрирует стремительный прогресс в области языковых моделей. Хотя мы все еще далеки от общего интеллекта, OpenAI продолжает двигаться к этой цели с каждой новой итерацией. Вполне вероятно, что впереди нас ждут впечатляющие разработки.

Источник: hackernoon.com